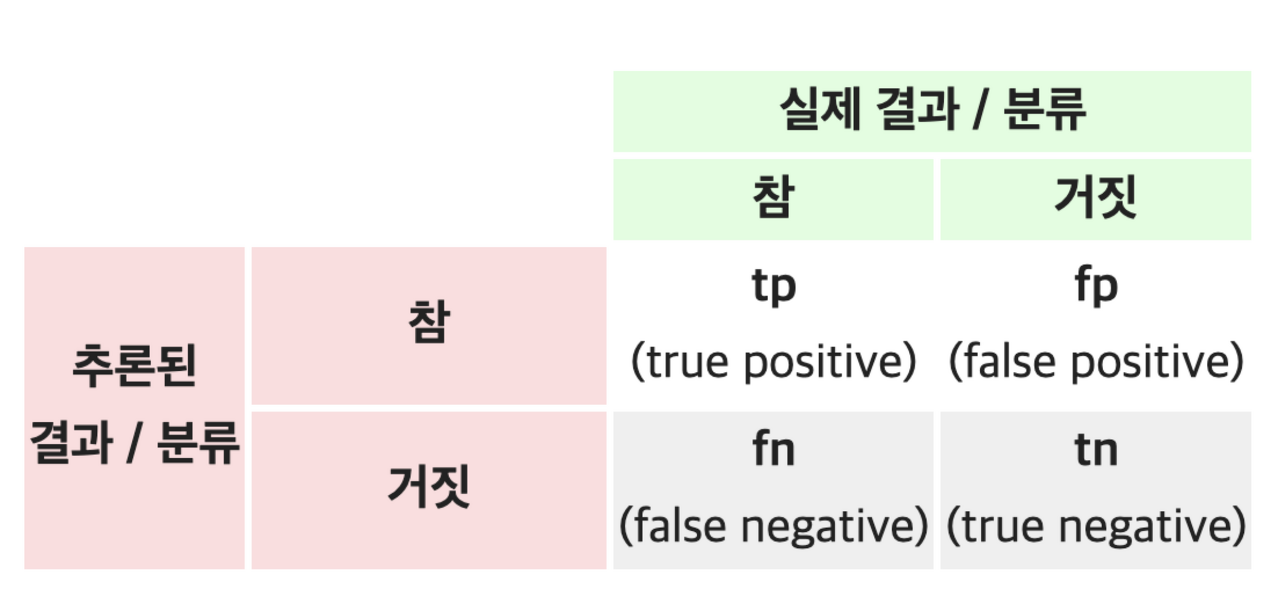

confusion matrix

모델이 맞혔을 때 → T

모델이 틀렸을 때 → F

모델의 예측값이 True -> P

모델의 예측 값이 False -> N

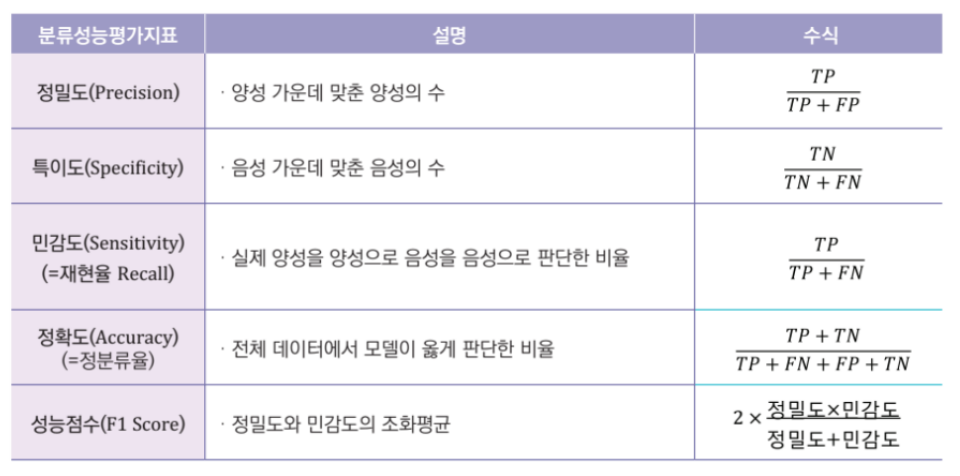

Precision : 예측값 기준 ,

tp / (tp + fp)

> 1종 오류, 맞지 않는 걸 보고 맞다고 하는 것

ex) 스펨메일이 아닌데 스팸메일로 잘못 예측

임신이 아닌데 임신으로 잘못 예측

- precision이 낮다 : 참이 아닌데 참이라고 한 것이 많다

- precision이 지나치게 높다 : 참으로 예측한 경우가 필요 이상으로 적다

Recall : 실제값 기준, tp / (tp + fn)

> 2종 오류, 맞는 것을 맞지 않다고 하는 것

ex) 암인데 암이 아니라고 잘못 예측

임신인데 임신이 아니라고 잘못 예측

- recall이 낮다 : 참인데 못 찾은 것이 많다

- recall이 지나치게 높다 : 참으로 예측한 경우가 필요 이상으로 많다

분류 성능 평가 지표

정확도 (Accuracy)

> 모델이 예측한 결과와 실제 결과가 얼마나 일치하는지를 측정.

정밀도 (Precision)

> 모델이 예측한 양성 클래스(positive class) 중에서 실제 양성 클래스인 것의 비율을 측정.

재현율 (Recall)

> 실제 양성 클래스 중에서 모델이 양성으로 예측한 것의 비율을 측정.

F1 스코어 (F1 Score)

> 정밀도와 재현율의 조화 평균값을 계산, 정밀도와 재현율을 모두 고려

→ 모델의 성능을 전반적으로 평가하는 데 유용.

오차 행렬 (Confusion Matrix)

> 실제 클래스와 모델이 예측한 클래스를 행과 열로 나타내는 행렬.

> 모델이 어떤 클래스를 잘 예측했고 어떤 클래스를 잘못 예측했는지를 시각적으로 확인 가능,

'멋쟁이사자처럼 AI School 8기(fin) > TIL(Today I Learn)' 카테고리의 다른 글

| [멋쟁이사자처럼 AI스쿨] TIL(23.3.28) 텍스트 분석, 자연어처리2 (0) | 2023.03.28 |

|---|---|

| [멋쟁이사자처럼 AI스쿨] TIL(23.3.27) 텍스트 분석, 자연어처리 (0) | 2023.03.27 |

| [멋쟁이사자처럼 AI스쿨] TIL(23.3.21) XGBoost, LightBGM (1) | 2023.03.21 |

| [멋쟁이사자처럼 AI스쿨] TIL(23.3.20), RandomSearchCV (0) | 2023.03.20 |

| [멋쟁이사자처럼 AI스쿨] TIL(23.3.17 ) - 태블로3 with 강승일 (0) | 2023.03.17 |